A versão original de esta história apareceu em Quanta revista.

Modelos de idiomas grandes funcionam bem porque são muito grandes. Os modelos mais recentes do OpenAI, Meta e Deepseek usam centenas de bilhões de “parâmetros” – os botões ajustáveis que determinam as conexões entre os dados e são ajustados durante o processo de treinamento. Com mais parâmetros, os modelos são mais capazes de identificar padrões e conexões, o que, por sua vez, os torna mais poderosos e precisos.

Mas esse poder tem um custo. Treinar um modelo com centenas de bilhões de parâmetros exige enormes recursos computacionais. Para treinar seu modelo Gemini 1.0 Ultra, por exemplo, o Google supostamente gastou US $ 191 milhões. Os grandes modelos de linguagem (LLMs) também exigem poder computacional considerável cada vez que respondem a uma solicitação, o que os torna notórios porcos de energia. Uma única consulta para chatgpt consome cerca de 10 vezes Tanta energia como uma única pesquisa no Google, de acordo com o Electric Power Research Institute.

Em resposta, alguns pesquisadores agora estão pensando pequenos. IBM, Google, Microsoft e OpenAI lançaram recentemente pequenos modelos de idiomas (SLMS) que usam alguns bilhões de parâmetros – uma fração de seus colegas LLM.

Modelos pequenos não são usados como ferramentas de uso geral, como seus primos maiores. Mas eles podem se destacar em tarefas específicas e mais restritas, como resumir conversas, responder às perguntas do paciente como um chatbot de assistência médica e coletar dados em dispositivos inteligentes. “Para muitas tarefas, um modelo de 8 bilhões de parâmetro é realmente muito bom”, disse Zico Kolterum cientista da computação da Universidade Carnegie Mellon. Eles também podem ser executados em um laptop ou telefone celular, em vez de um enorme data center. (Não há consenso sobre a definição exata de “pequena”, mas os novos modelos todos atingem cerca de 10 bilhões de parâmetros.)

Para otimizar o processo de treinamento para esses pequenos modelos, os pesquisadores usam alguns truques. Modelos grandes geralmente raspam dados de treinamento bruto da Internet, e esses dados podem ser desorganizados, confusos e difíceis de processar. Mas esses grandes modelos podem gerar um conjunto de dados de alta qualidade que pode ser usado para treinar um modelo pequeno. A abordagem, chamada destilação do conhecimento, recebe o modelo maior para repassar efetivamente seu treinamento, como um professor dando aulas a um aluno. “O motivo (SLMS) fica tão bom com modelos tão pequenos e dados tão pequenos é que eles usam dados de alta qualidade em vez das coisas confusas”, disse Kolter.

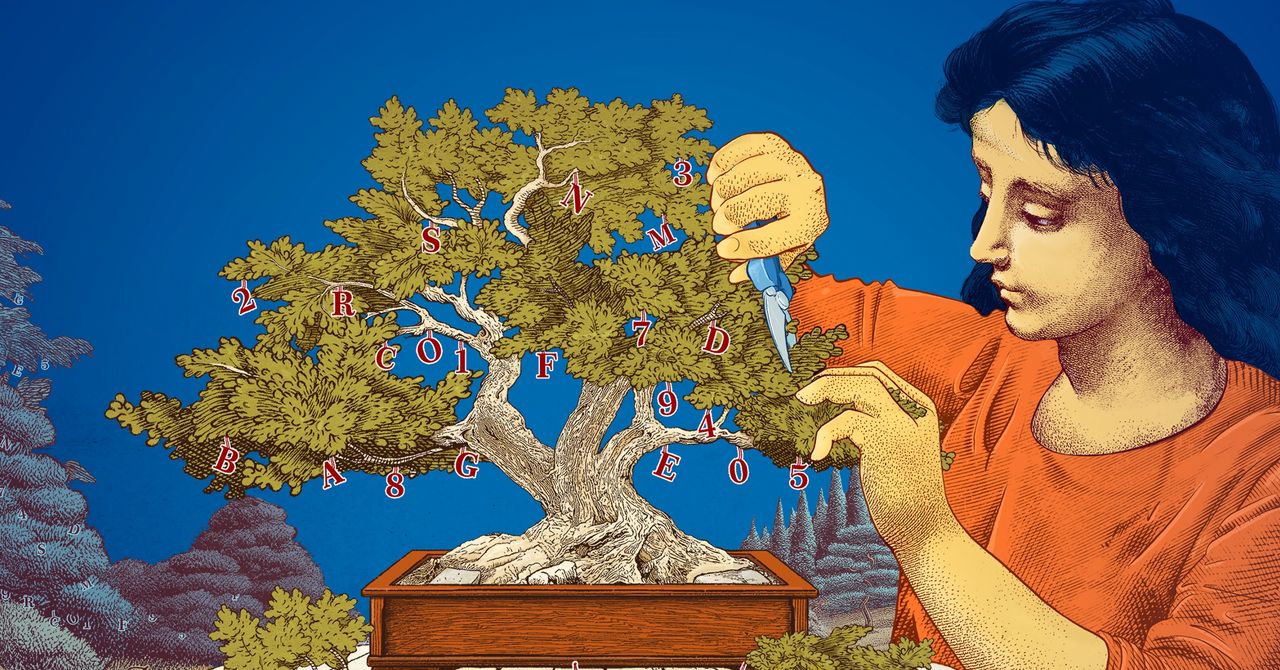

Os pesquisadores também exploraram maneiras de criar pequenos modelos começando com grandes e aparando -os. Um método, conhecido como poda, implica remover partes desnecessárias ou ineficientes de um Rede Neural– A ampla rede de pontos de dados conectados subjacentes a um modelo grande.

A poda foi inspirada por uma rede neural da vida real, o cérebro humano, que ganha eficiência ao fechar conexões entre sinapses à medida que uma pessoa envelhece. As abordagens de poda de hoje remontam a Um artigo de 1989 em que o cientista da computação Yann Lecun, agora na Meta, argumentou que até 90 % dos parâmetros em uma rede neural treinada poderiam ser removidos sem sacrificar a eficiência. Ele chamou o método de “dano cerebral ideal”. A poda pode ajudar os pesquisadores a ajustar um pequeno modelo de linguagem para uma tarefa ou ambiente específico.

Para os pesquisadores interessados em como os modelos de idiomas fazem as coisas que fazem, os modelos menores oferecem uma maneira barata de testar novas idéias. E como eles têm menos parâmetros do que modelos grandes, seu raciocínio pode ser mais transparente. “Se você deseja fazer um novo modelo, precisa tentar as coisas”, disse Leshem Choshenum cientista de pesquisa no MIT-IBM Watson AI Lab. “Modelos pequenos permitem que os pesquisadores experimentem apostas mais baixas.”

Os grandes e caros modelos, com seus parâmetros cada vez maiores, permanecerão úteis para aplicativos como chatbots generalizados, geradores de imagens e descoberta de medicamentos. Mas para muitos usuários, um modelo pequeno e direcionado também funcionará, embora seja mais fácil para os pesquisadores treinarem e construir. “Esses modelos eficientes podem economizar dinheiro, tempo e calcular”, disse Choshen.

História original reimpresso com permissão de Quanta revistaAssim, uma publicação editorialmente independente do Fundação Simons cuja missão é melhorar a compreensão pública da ciência, cobrindo os desenvolvimentos e tendências da pesquisa em matemática e ciências físicas e da vida.